- Sea Q el contexto actual. LOCO-I considera un máximo de 1094 contextos distintos.

- Sea N[Q] el número de ocurrencias de cada contexto. Inicialmente N[Q] ← 0 ∀Q.

- Sea B[Q] el error de predicción acumulado en cada contexto. Inicialmente B[Q] ← 0 ∀Q.

- Sea A[Q] la suma de los valores absolutos de los errores de predicción para cada contexto. Inicialmente A[Q] ← 0 ∀Q.

- Sea C[Q] los valores de cancelación del bias. El bias es un valor que sumado a la predicción espacial provoca que su media sea 0. Inicialmente C[Q] ← 0 ∀Q.

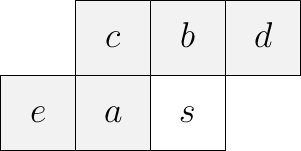

- Calcular el gradiente local. Para ello se efectúan las 4 diferencias (ver la

siguiente figura):

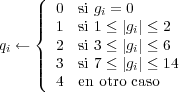

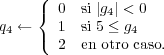

- Cuantificar los gradientes según:

para i = 1,2,3 y

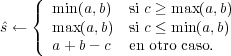

- Construir la predicción inicial:

- Cancelar el bias:

![{ ˆs +C [Q ] si g1 > 0

ˆs ← ˆs - C [Q ] en otro caso.](texput143x.png)

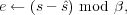

- Calcular el error de predicción:

donde β es el número de bits por punto. Esto provoca que el error de predicción sea proyectado desde el intervalo [-α + 1,α - 1] al intervalo [-α∕2,α∕2 - 1] donde α = 2β es el tama no del alfabeto.

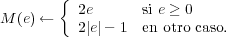

- Barajar los errores de predicción negativos y positivos generando una

distribución de probabilidades que es decreciente con el índice del error. Esto

se realiza según el siguiente mapeo:

Tras dicho mapeo, los errores de predicción se ordenan según: 0, -1, +1, -2, +2,

,2β - 1.

,2β - 1.

- Se emite un código de Rice que codifica el símbolo M(e) para k = ⌈log 2(A[Q])⌉.

- B[Q] ← B[Q] + e.

- A[Q] ← A[Q] + |e|.

- Si N[Q] = RESET, entonces: (donde 64 ≤ RESET ≤ 256)

- A[Q] ← A[Q]∕2.

- B[Q] ← B[Q]∕2.

- H[Q] ← N[Q]∕2.

- N[Q] ← N[Q] + 1.

- La actualización del valor para la cancelación del bias es algo más compleja. Si

el error de predicción inicial en el contexto Q no tiene media 0, el nivel de

compresión decae severamente porque las medias de la distribución de Laplace

real y la modelada no coinciden. Para evitar esto, C[Q] almacena un valor

proporcional a B[Q]∕N[Q] que es sumado a la predicción inicial para cancelar

el bias.

Además, C[Q] es el encargado de solucionar otro problema derivado del barajamiento producido por M(e) debido al cual, se tiende a asignar un código más corto al error negativo que al respectivo error positivo.

Con todo esto, el algoritmo para la actualización de C[Q] es el siguiente [12]:

- Si B[A] ≤-N[Q], entonces:

- B[Q] ← B[Q] + N[Q].

- Si C[Q] > -128, entonces:

- C[Q] ← C[Q] - 1.

- Si B[Q] ≤-N[Q], entonces:

- B[Q] ←-N[Q] + 1.

- Si no:

- Si B[Q] > 0, entonces:

- B[Q] ← B[Q] - N[Q].

- Si C[Q] < 127, entonces:

- C[Q] ← C[Q] + 1.

- Si B[Q] > 0, entonces:

- B[Q] ← 0.

- Si B[Q] > 0, entonces:

- Si B[A] ≤-N[Q], entonces: